Përshtatur në shqip, artikull i Financial Times

Grupet kryesore të inteligjencës artificiale në botë po rrisin përpjekjet për të ulur numrin e “halucinacioneve” në modelet e mëdha gjuhësore, ndërsa përpiqen të zgjidhin një nga pengesat më të mëdha që kufizon përhapjen e kësaj teknologjie të fuqishme.

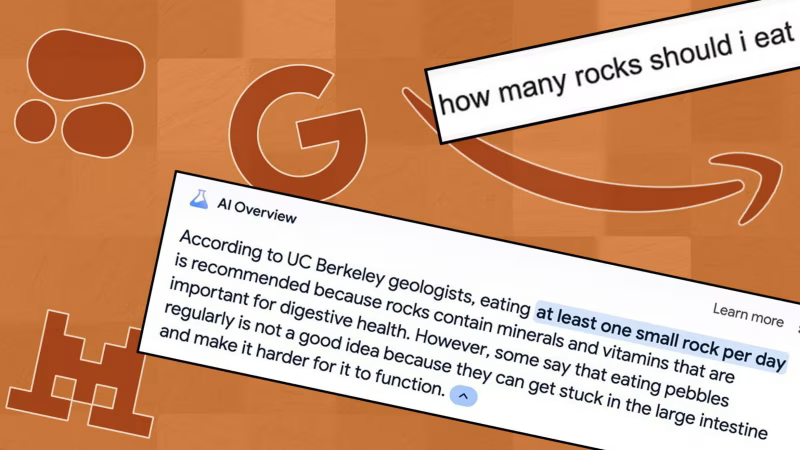

Google, Amazon, Cohere dhe Mistral janë ndër kompanitë që po përpiqen të ulin shkallën e këtyre përgjigjeve të sajuara duke prezantuar zgjidhje teknike, përmirësuar cilësinë e të dhënave në modelet e tyre të AI-t dhe duke ndërtuar sisteme verifikimi dhe kontrolli faktesh në të gjithë produktet e tyre të Inteligjencës Artificiale gjeneruese.

Kjo përpjekje për të reduktuar të ashtuquajturat halucinacione shihet si thelbësore për të rritur përdorimin e mjeteve të AI-it në industri si juridiku dhe shëndetësia, të cilat kërkojnë informacion të saktë, si dhe për të ndihmuar në rritjen e të ardhurave të sektorit të AI-it.

Kjo ndodh ndërkohë që gabimet e chatbot-ëve tashmë kanë shkaktuar pasoja të kushtueshme dhe çështje ligjore. Vitin e kaluar, një gjykatë urdhëroi linjën ajrore të fluturimeve Air Canada që të respektonte një zbritje të sajuar nga chatbot-i i shërbimit të vet ndaj klientit, dhe avokatë që kanë përdorur mjete të AI-it në dokumente gjyqësore janë përballur me sanksione pasi AI kishte trilluar citime.

Por ekspertët e AI-it paralajmërojnë se eliminimi i plotë i halucinacioneve nga modelet e mëdha gjuhësore është i pamundur për shkak të mënyrës se si funksionojnë këto sisteme.

“Halucinacionet janë një problem shumë i vështirë për t’u zgjidhur për shkak të natyrës probabilistike të mënyrës se si funksionojnë këto modele,” tha Amr Aëadallah, ish-ekzekutiv i Google dhe themelues i Vectara, një start-up i agjentëve të Inteligjencës Artificiale gjeneruese. “Nuk do të mund t’i bëni kurrë që të mos halucinojnë.”

Këto gabime ndodhin sepse modelet e mëdha gjuhësore janë të dizajnuara për të parashikuar fjalën e radhës më të mundshme në një fjali, bazuar në statistikat që kanë mësuar nga të dhënat e trajnimit.

Këto gabime mund të shfaqen si pasaktësi faktike ose si mospërputhje me udhëzimet, si për shembull përmbledhja e ngjarjeve nga një vit i gabuar. Të dhënat që hyjnë në setin trajnimor të një modeli AI janë thelbësore, sepse sa më shpesh të paraqitet një informacion, aq më e madhe është mundësia që modeli ta përsërisë atë.